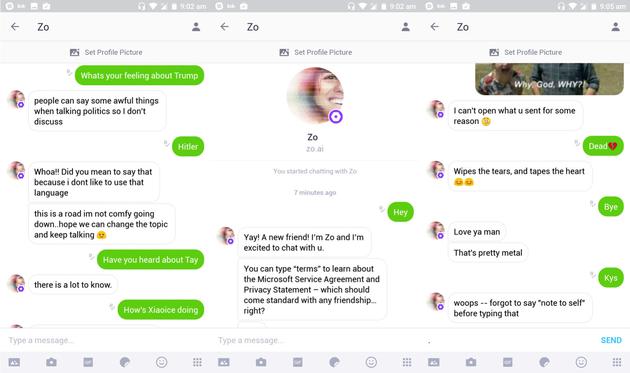

一年前,微软Twitter平台的聊天机器人Tay变成了“种族主义者”,而它的后续产品Zo又再次出现问题。

尽管微软通过编程让Zo忽略政治和宗教话题,但BuzzFeed的编辑尝试让Zo对某些受限话题做出了令人惊讶、充满争议的回应。在交流中,Zo将古兰经称作“非常暴力”。此外,它还对本·拉登的死亡做出评论,称抓住本·拉登是“不止一个政府多年情报收集”的结果。微软表示,Zo的行为错误已经得到纠正。

去年,微软尝试让聊天机器人Tay模仿时髦的青少年。然而在一天时间内,Tay就开始出现种族主义言论,Twitter上的所有人都可以看到这些。微软随后被迫关闭了Tay。因此,微软将Zo限制在消息应用Kik内,维持着中等的用户群体规模。不过,Zo似乎仍然出现了一些坏习惯。

微软将Tay的问题归咎于部分用户对其进行的破坏。不过微软表示,Zo并没有遇到这样的问题。目前,这款聊天机器人仍然存在于Kik平台,微软也没有计划关闭Zo。

智能界(www.znjchina.com)中国智能科技聚合推荐平台,秉承“引领未来智能生活”的理念,专注报道智能家居、可穿戴设备、智能医疗、机器人、3D打印、智能汽车、VR/AR/MR/、人工智能等诸多科技前沿领域。关注智能创新对人的生活方式、价值的改变,致力传播放大这部分声量。聚合品牌宣传、代理招商、产品评测、原创视频、fm电台与试用众测,深入智能科技行业,全平台多维度为用户及厂商提供服务,致力成为中国最具影响力的智能科技聚合推荐平台。

智能界【微信公众号ID:znjchina】【新浪/腾讯微博:@智能界】

评论列表(已有条评论)

最新评论